Agility is the new edge…

Comme en course à pied, l’essentiel n’est pas de courir plus vite ou plus loin que les autres, mais de savoir ajuster sa foulée : avancer avec constance, intelligence et maîtrise. L’IA n’échappe pas à cette logique. Ce qui compte n’est plus la taille du modèle, mais sa pertinence, son adéquation au terrain, sa sobriété. Autrement dit : la bonne ressource, au bon moment, pour le bon usage.

« Rien ne sert de courir, il faut partir à point. » — Jean de La Fontaine, Le Lièvre et la Tortue

1 — LLM vs. SLM : le constat d’une opposition entre taille et frugalité

Entre prouesses techniques et contraintes énergétiques, l’IA entre dans une nouvelle ère de maturité et de questionnement.

D’un côté, les modèles géants menés par les mastodontes américains — OpenAI, Google, Anthropic, Meta — financés par des dizaines de milliards de dollars, et alimentés par des infrastructures toujours plus colossales.

De l’autre, un monde qui vise à faire « mieux avec moins », porté par une culture de sobriété, d’optimisation locale et d’accès plus démocratique.

Les LLM (Large Language Models) grand public, tels que Gemini, ChatGPT ou Copilot, transforment déjà certaines stratégies go-to-market en analysant, automatisant et simulant plus rapidement, tout en contextualisant les décisions métier. Mais cette dynamique de « toujours plus » s’oppose désormais à celle promue par les SLM (Small Language Models) : plus frugaux, mieux adaptés, moins coûteux — et souvent, plus efficaces sur la tâche cible.

2 — La double contrainte de l’IA : finance & énergie

Pourquoi cette alternative frugale devient-elle vitale ? Parce que le modèle dominant actuel se heurte à un mur. Les grands acteurs de l’IA : Microsoft, OpenAI, Google, Anthropic et Meta sont aujourd’hui engagés dans une surenchère technologique et énergétique. Des chiffres comme ceux de ChatGPT donnent le vertige, qui avec son modèle GPT-5 consommerait 8,6 fois plus d’électricité que son prédécesseur GPT-4, tandis que son fonctionnement représenterait près de 700 000 $ par jour. À cette instabilité financière s’ajoute un point technique crucial : accroître le nombre de paramètres ou la puissance de calcul n’offre ni davantage d’exactitude ni une meilleure adéquation métier, et la polyvalence ne garantit pas la performance.

Alors, une question s’impose :

Faut-il vraiment mobiliser des centaines de milliards de paramètres et des gigawatts d’énergie pour automatiser… un simple reporting ?

2.1 — Rentabilité & dépendance : une économie sous tension

Derrière les démonstrations technologiques spectaculaires, la réalité économique et financière du secteur de l’intelligence artificielle reste fragile.

Le coût d’entraînement des modèles de pointe est astronomique : il peut atteindre le milliard de dollars par an. Cela inclut les données, les talents rares, les GPU et la maintenance des datacenters.

L’économie de l’IA repose sur une logique circulaire d’investissement et d’anticipation de profits futurs plutôt que sur de la rentabilité immédiate. Les acteurs majeurs sont intrinsèquement liés : ils sont à la fois fournisseurs, clients et investisseurs les uns des autres. Microsoft, par exemple, finance OpenAI, exploite ses modèles et s’équipe de puces Nvidia, un acteur qui investit lui-même dans cet écosystème.

2.2 — La Surenchère Énergétique : infrastructure & empreinte carbone

Derrière les annonces de performance et d’innovation se cache un enjeu plus fondamental : la course à l’énergie. Qui disposera de la puissance nécessaire pour entraîner et déployer les IA de demain ?

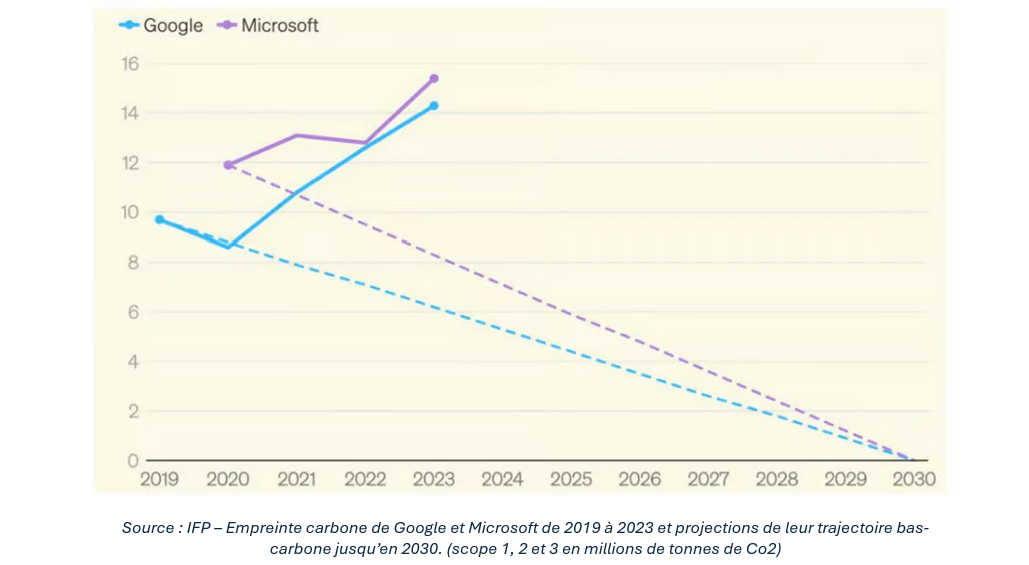

Cette pression se traduit par des projets massifs comme Colossus 2 de xAI, un supercalculateur destiné au modèle Grok, dont la puissance pourrait atteindre 1 gigawatt d’ici 2026. Les datacenters figurent désormais parmi les plus gros postes de consommation électrique : en Irlande, ils représentent déjà 20 % de l’électricité nationale et pourraient atteindre 28 % d’ici 2031. À l’échelle mondiale, l’IA pourrait représenter au moins 35 % de la consommation électrique des datacenters d’ici 2030 selon The Shift Project. Même lorsque l’efficacité énergétique progresse, l’effet rebond lié à l’augmentation massive de l’utilisation des modèles (inférence) annule souvent ces gains et augmente l’impact carbone. Les bilans énergétiques des géants technologiques illustrent cette tendance : les émissions de CO₂ de Google ont bondi de +48 % en cinq ans, en grande partie à cause de ses datacenters dédiés à l’IA.

Derrière ces chiffres, une réalité simple demeure : l’énergie devient la nouvelle matière première de l’IA. Dans ce contexte de tensions financières et énergétiques, une évidence s’impose : le modèle actuel n’est plus soutenable. C’est ici qu’émerge la nécessité d’une véritable stratégie de rupture.

3 — Stratégie de rupture : vers une IA utile, adaptée et mesurable

Les limites technologiques, économiques et environnementales imposent de repenser le déploiement de l’IA. On passe ainsi du réflexe « le plus gros = le meilleur » à une approche centrée sur la pertinence, l’adéquation et la sobriété. C’est le point de départ d’une stratégie de rupture qui repose sur 3 leviers principaux : choisir le bon modèle, optimiser le context engineering et tirer parti de la multimodalité.

3.1 — Choisir le bon modèle – L’ère du Small Is Beautiful – Les SLM

L’étape initiale et la plus cruciale pour l’utilisabilité est de répondre aux questions fondamentales : « Quel est mon besoin réel ? » et « Quels sont mes moyens (financiers, énergétiques, techniques) ? »

Cette réflexion stratégique conduit à opposer deux catégories de modèles :

Les LLM : Des modèles de référence pour la polyvalence, la créativité et les tâches généralistes. Cependant, ils sont intrinsèquement coûteux, énergivores et imposent une forte dépendance au cloud.

Les SLM : Ces modèles plus compacts et spécialisés incarnent la voie de la sobriété. Ils sont frugaux, peuvent être déployés en local (on-prem) ou sur des appareils mobiles, et sont souvent plus performants que leurs homologues géants sur des tâches ciblées. Ils sont fréquemment formés grâce à des techniques comme la distillation, la quantification ou le pruning, qui permettent de les rendre plus petits, rapides, légers et efficaces, tout en conservant leurs performances et en réduisant ainsi drastiquement leur empreinte carbone.

L’objectif est clair : Adapter le modèle à l’usage, et non l’inverse. Le paradigme du Small is Beautiful s’impose, valorisant l’efficacité spécifique sur la puissance brute généraliste. Mais une question se pose, comment tirer pleinement parti de ces modèles tout en maximisant la pertinence des réponses ? C’est là que le context engineering prend toute son importance.

3.2 — Optimiser la pertinence : le context engineering

Le context engineering émerge comme la compétence clé en IA, prenant le relais du prompt engineering. Il vise à optimiser la sélection, la structuration et l’enrichissement du contexte transmis au modèle afin d’obtenir des réponses plus pertinentes, plus fiables et mieux adaptées aux besoins métiers.

Les LLM disposent aujourd’hui de fenêtres contextuelles très étendues — jusqu’à 1 million de tokens (ex. : Gemini 2.5) — permettant d’ingérer d’importants volumes d’informations. À l’inverse, les SLM restent limités, souvent inférieurs à 10 000 tokens, et nécessitent donc une gestion sélective des informations. Pour maximiser la qualité des réponses, il faudrait prioriser les sources, intégrer des données dynamiques via le RAG, filtrer et compresser les contenus, fournir des exemples pertinents et maintenir la continuité du contexte au fil des échanges.

Une innovation récente illustre particulièrement cette logique de compression : DeepSeek-OCR (optical character recognition). Ce procédé transforme le texte contenu dans des images, ou des documents scannés en texte éditable et exploitable par un ordinateur. Il réduit la taille des données d’environ 10 % tout en conservant 97 % de l’information, facilitant ainsi le traitement de contenus longs et ouvrant la voie à l’intégration future de signaux sensoriels.

Au-delà de l’optimisation du contexte, une autre évolution majeure transforme l’usage de l’IA : la capacité des modèles à comprendre plusieurs types de données.

3.3 — Tirer parti de la multimodalité : voir, entendre et comprendre

Les modèles d’IA de nouvelle génération sont désormais capables de combiner plusieurs formats de données — texte, image, audio, vidéo — ouvrant la voie à des cas d’usage plus riches, plus automatisés et plus robustes.

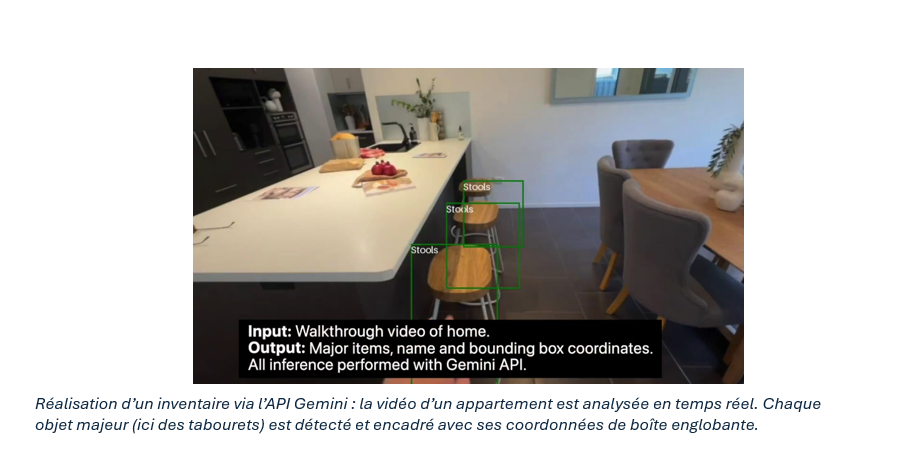

Par exemple, un utilisateur peut filmer son appartement en marchant à travers les différentes pièces et demander à l’IA d’identifier automatiquement les objets présents et d’en créer une base de données structurée. (Ex : Gemini)

Cette capacité multimodale renforce l’analyse et la compréhension contextuelle du modèle, rendant les interactions plus naturelles et plus nuancées.

En contrepartie, elle implique un coût énergétique et d’intégration plus élevé. L’enjeu redevient donc un arbitrage classique : pertinence métier vs coût d’implémentation. Ces approches ne sont pas seulement théoriques ; elles sont déjà mises en œuvre par des acteurs majeurs qui prouvent qu’une IA performante et sobre est possible.

3.4 — Mistral et la voie européenne

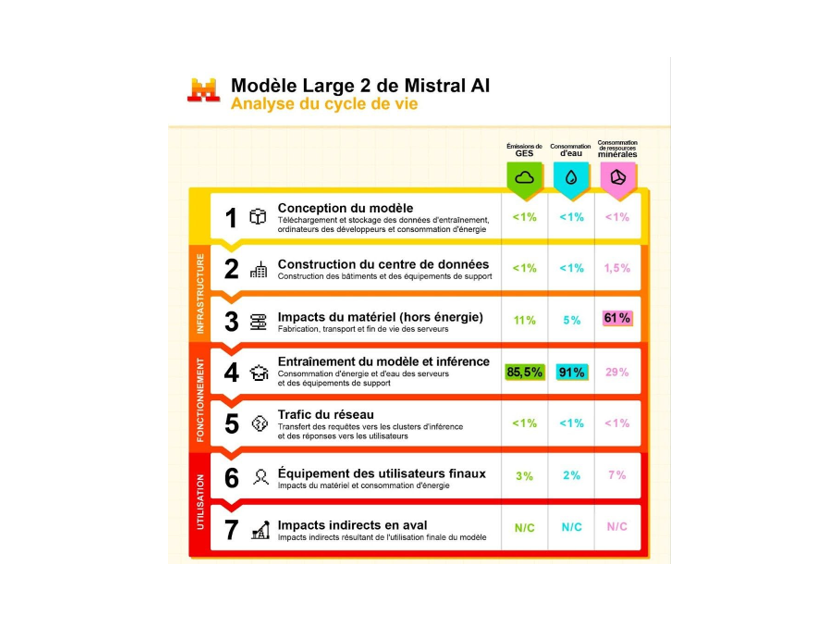

Mistral AI en est un bon exemple. Face aux géants américains, elle incarne une approche européenne singulière fondée sur la sobriété et la transparence. La startup privilégie des modèles ouverts et compacts, certains sous les 10 milliards de paramètres. Ils offrent des performances remarquables pour leur taille, parfois comparables aux LLM sur certaines tâches mais pour un coût bien inférieur. Elle se distingue également par la publication d’analyses de cycle de vie (ACV) et par une collaboration avec Carbone 4 et l’ADEME afin d’établir un référentiel environnemental solide.

Son portefeuille est équilibré, combinant des modèles performants comme Mistral Medium 3.1 (~24 milliards de paramètres) et Pixtral Large : son modèle multimodal. Mistral montre ainsi qu’allier performance, sobriété et accessibilité est possible : leur propre chatbot tourne d’ailleurs sur un modèle Medium, à la fois suffisant et optimisé. Ici, la contrainte devient une force. Cette voie européenne est celle que nous défendons et mettons en œuvre au sein de notre écosystème.

4 — Notre vision – une IA utile, mesurable et responsable

Notre conviction est simple : On peut faire mieux avec moins — en cherchant la performance juste, plutôt que la démesure technologique.

Concrètement, nous appliquons cette philosophie d’abord à nos propres projets : moteurs de recherche internes, algorithmes de matching, RAG Decenz, agents spécialisés, automatisation de la gestion des factures et des notes de frais.

Nous la déployons également chez nos clients au travers d’une démarche structurée : audit → sélection du modèle → POC → déploiement responsable, en intégrant dès le départ les indicateurs clés : coût, latence, consommation (kWh) et impact carbone (gCO₂e).

Cette vision s’accompagne d’un travail de fond sur la culture : formations, acculturation à la sobriété, animation de communautés spécialisées, et implication dans le consortium Decenz. Elle se traduit aussi dans nos engagements : –14 % d’empreinte carbone en 2024, et 15 % de notre chiffre d’affaires dédié aux ODD.

Notre approche technique est résolument modulaire : plutôt qu’un LLM multimodal « fourre-tout », nous privilégions des briques spécialisées — un modèle vision pour l’image, un modèle langage dédié pour le texte — afin d’optimiser la consommation, la performance et le coût.

Bref : produire moins vite… mais mieux.

Le débat a désormais changé de nature.

5- Conclusion — Repenser l’IA pour la capacité à durer

Le débat n’est plus : qui a le plus gros modèle ?

La vraie question devient : qui déploie l’IA la plus utile, la mieux adaptée et la plus sobre ?

Comme dans une course, l’enjeu n’est pas la vitesse pure, mais la capacité à durer : optimiser son geste, s’adapter au terrain, à la météo et au contexte.

Small is beautiful.

L’avenir appartiendra à celles et ceux qui sauront façonner l’IA à la mesure de leurs besoins — sans excès, mais avec précision et intention.

Pour aller plus loin

Vous souhaitez explorer un cas d’usage, échanger sur vos enjeux IA, ou construire une démarche responsable ?

→ Parlons-en.

Curieux de découvrir d’autres articles dans le même thème ?

« Le Shift Project décrypte l’avenir énergétique et climatique de l’IA » – Notre article sur les centres de données, la consommation d’énergie et l’IA.

« L’IA éthique : naviguer entre progrès et prudence » – une de nos réflexions sur les enjeux éthiques de l’IA.

« Intelligence artificielle, données, calculs : quelles infrastructures dans un monde décarboné ? » – rapport de The Shift Project sur l’impact environnemental des infrastructures IA.

Pour ne rien manquer, suivez-nous aussi sur LinkedIn et restez informés de nos actualités, réflexions et événements : notre page LinkedIn

Alexis Poirot